- 인간처럼 생각하는 기계의 가능성을 탐구한 튜링 테스트Turing Test

16-17세기의 위대한 철학자인 르네 데카르트는 인간을 모방하는 능력이 있는 기계가 있다고 가정하고 이를 탐구했습니다. 그는 탐구 결과 인간의 도덕성까지도 모방하는 기계가 있어도 인간은 기계와 인간을 구분할 수 있다고 결론을 지었습니다. 그는 기계와 인간을 구분하는 방법으로 인간은 적절한 언어를 구사하는 능력이 있지만 기계는 적절한 언어를 구사할 수 있는 능력은 가질 수 없다고 생각했습니다. 르네 데카르트의 철학은 이후 철학자에게도 영향을 미쳐 상황에 적절한 언어를 구사하는 능력의 여부는 인간과 기계를 구분하는 가장 핵심적인 장벽으로 여겨졌습니다.

컴퓨터의 개념을 제시한 앨런 튜링 역시 기계가 인간처럼 상황에 적절한 언어를 구사할 수 있는지 진지하게 탐구했습니다. 그는 1947년 IntelligentMachinery라는 보고서에 기계가 인간처럼 지능적인 행동을 보일 수 있는지 연구한 내용을 삽입하며 지능이 있는 기계에 대해 연구했습니다. 앨런 튜링 외에도 수많은 수학자들은 1940년대부터 기계가 스스로 생각하는 지능을 보유할 수 있는지 철학적으로 탐구했습니다. 이 때 많은 수학자와 철학자는 "기계가 지능을 보유할 수 있는가?"라는 질문에 기계와 지능을 명확히 정의하는 것부터 접근하려고 했습니다.

하지만 앨런 튜링은 다른 방법으로 "기계가 지능을 보유할 수 있는가?" 질문에 대답하려고 했습니다. 그는 1950년 논문을 발표하며 튜링 테스트Turing Test로 지능을 가진 기계를 판단하는 방법을 제시했습니다. 튜링 테스트Turing Test는 한 평가자가 있고 평가자의 질문에 응답하는 기계와 사람이 있되 평가자는 기계와 사람을 볼 수 없는 환경에서 시작합니다. 평가자는 둘에게 질문을 던지고 기계와 사람이 그 질문에 응답하는 문서를 작성합니다. 그럼 평가자는 기계와 사람의 응답을 읽고 기계가 작성한 응답이 사람이 작성한 응답이라고 판단하면 그것은 기계가 지능을 보유한 것을 증명한 것으로 판단하기로 했습니다. 이런 튜링 테스트Turing Test는 간단하면서도 '지능을 가진 기계'를 판단하는 중요한 척도가 되었습니다.

- 인공지능을 학문으로 끌어올리다

튜링 테스트Turing Test는 지능을 가진 기계를 판단하는 모델이 되었습니다. 그리고 당시 유행하던 사이버네틱스Cybernetics를 연구하던 학자들은 사이버네틱스Cybernetics의 일환으로 지능을 보유한 기계에 대해서도 연구했습니다. 특히 1950년대에 다트머스 대학교에서 수학을 연구하던 존 매카시는 1956년 어느 여름 다트머스 대학교에서 다트머스 워크샵을 열어 지능을 가진 기계에 대한 연구를 본격적으로 시작했습니다. 워크샵에는 존 매카시 외에도 마빈 민스키, 클로드 섀넌 등 수학과 컴퓨터학, 인지심리학 등 다양한 분야의 최고 전문가 10명이 모였습니다.

워크샵에 참석한 인재들은 토론을 거쳐 기계에 지능을 부여할 수 있다고 판단했고 이를 인공지능Artificial Intelligence로 정의했습니다. 그리고 Darthmouth Summer Research Project on Artificial Intelligence라는 이름으로 인공지능에 대한 연구를 시작함을 알렸습니다. 이렇게 다트머스 대학교에서 인간의 지능을 기계에 구현하는 인공지능 학문이 등장했습니다.

- 인공신경망을 만드는 법

인공지능의 핵심 기술은 인간의 중추신경계인 뇌를 모방하는 것이었습니다. 이에 따라 1957년 인공지능을 구현할 방법으로 인간 두뇌의 신경망을 모방한 인공신경망 개념이 제시되었습니다. 코넬 항공 연구소의 프랑크 로젠블라트는 인간의 신경세포를 탐구하고 이를 기계에 동일하게 적용하려고 했습니다.

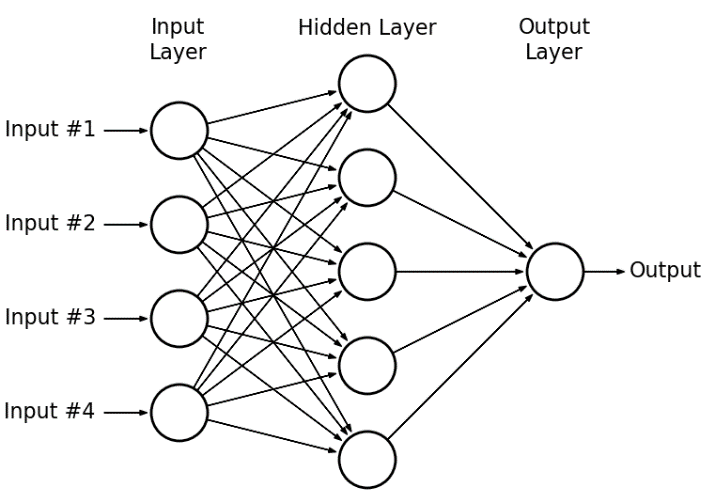

자극을 받아들이고, 자극을 전달하고, 자극을 다른 신경세포에 전달하는 말단 세가지 구조로 구성되어있는 생명체의 신경세포를 따라 수용층, 연합층, 반응층 세 단계로 인공신경망 모델을 제시했습니다. 그래서 수용층은 수많은 데이터 값을 가지고 그 많은 데이터 값을 연합층에서 하나로 합친 뒤 이를 반응층에 보내 기계가 판단하는 구조로 구성되어 있었습니다. 그는 이를 퍼셉트론Perceptron이라고 정의했습니다.

퍼셉트론 모델은 생명체의 지능 형성과정을 탐구한 신경망 이론을 기계에 가장 적합하게 적용한 모델로 평가되었습니다. 프랑크 로젠블라트는 Mark I이라는 거대한 기계를 만들어 퍼셉트론을 구현했습니다. Mark I은 사진기가 있어 사진으로 그림을 촬영한 뒤 퍼셉트론 모델로 구현한 장치를 거쳐 사진에 대해 판단하는 거대한 기계였습니다.

프랑크 로젠블라트는 사진기로 서로 다른 두 대상의 그림을 그린 사진을 찍어 Mark I 기계에게 그림을 보여주고 그림의 패턴을 인식할 수 있는지 테스트해봤습니다. 테스트 결과 기계는 그림에서 공통된 부분을 발견해 어느 정도 패턴을 인식할 수 있었습니다. 하지만 이는 컴퓨터의 AND와 OR 연산자 논리를 이용해 구분할 수 있는 패턴만 인식이 가능했습니다. 그럼에도 스스로 판단하는 기계가 등장하자 학계는 판단하는 기계를 실제로 만들 수 있음에 놀랐습니다. 덕분에 인공지능을 연구하는 학계와 수학 등 다양한 학문에서 퍼셉트론의 개념을 적용해 스스로 판단을 내리는 인공지능을 연구했습니다. 이는 대부분 Mark I보다 더 좋은 성능을 내는 기계에 대한 연구였습니다.

- 침체와 성장을 반복하다

허나 퍼셉트론을 개량해 더 다양한 상황을 판단하는 연구는 진척이 빠르지 않았고 설상가상으로 1969년 퍼셉트론을 연구한 마빈 민스키와 시모어 페퍼트는 퍼셉트론 모델로는 AND와 OR 연산자 등 선형 분리가 가능한 문제가 아닌 다른 문제(XOR 문제)들은 데이터를 구분하고 판단할 수 없음을 수학적으로 증명했습니다. 해당 논문이 나오며 퍼셉트론 모델이 한계를 드러내자 인공지능 연구에 대한 열기는 순식간에 식어들었고 인공지능의 암흑기가 시작되었습니다. 많은 인공지능 연구 프로젝트가 중단되었고 인공지능은 불가능할 것이라는 비관적인 전망이 주를 이루었습니다.

하지만 그럼에도 소수의 학자들은 인공지능에 대한 가능성을 믿고 희망을 잃지 않았습니다. 그들은 별다른 지원이 없는 상태에서도 인공지능을 연구했고 비선형 데이터를 판단할 수 있는 모델을 고민했습니다. 1986년 제프리 힌튼은 퍼셉트론 모델을 수정해 새로운 모델을 만들었습니다. 그는 기존 퍼셉트론에 히든 레이어Hiden Layer를 추가해 인공신경망을 여러 층으로 쌓아 가능성을 일단 여러 개로 확장했습니다.

그 뒤 인공지능이 출력값을 내놓으면 정답인 실제 값과 비교해 얼마나 다른지 판단한 뒤 인공지능이 판단한 순서의 역순으로 오차를 잡아가는 역전파 알고리즘을 제시해 비선형 데이터인 XOR 문제를 해결할 수 있는 모델을 제시했습니다. 이 모델은 XOR 문제도 해결하며 기존 퍼셉트론이 해결한 AND, OR 문제 역시 무리없이 잘 수행했습니다. 다층 퍼셉트론과 역전파 모델은 인공지능이 선형 문제와 비선형 문제, 즉 모든 문제를 해결할 수 있는 모델이며 인공지능의 가능성을 다시 증명한 모델이었습니다.

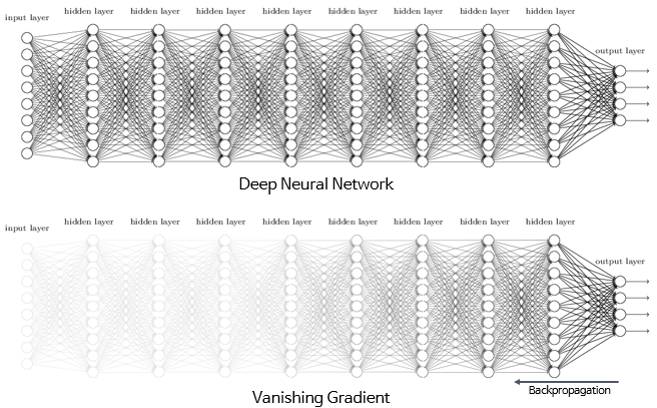

1986년 다층 퍼셉트론 모델 등장 이후 인공지능은 다시 주목을 받았고 인공지능 연구에 대한 지원 역시 살아났습니다. 하지만 이내 다층 퍼셉트론 모델의 한계도 드러났습니다. 대규모 데이터를 판단하려면 더 많은 히든 레이어Hidden Layer과 그 레이어들을 연결할 더 촘촘하고 복잡한 인공신경망이 필요했는데 인공신경망이 많아지면 그만큼 역전파 알고리즘으로 오차를 조정하기가 어려워졌습니다. 그래서 초기 단계의 히든 레이어Hidden Layer는 오차가 조정이 잘 되지 않는 기울기 문제가 발생했고 이 문제를 해결하지 못해 인공지능 발전은 또다시 벽에 부딫힌 상태로 오랜 침체기를 겪었습니다.

- 기계가 스스로 학습하는 딥러닝Deep Learning

인공지능 학자들이 기울기 문제라는 벽에 가로막혀 한탄하는 동안 반도체 기술은 비약적으로 성장하며 컴퓨터의 성능은 무서운 속도로 빨라졌습니다. 때문에 예전처럼 소자들을 물리적으로 연결할 필요 없이 한 소자로 훨씬 복잡하고 다양한 일을 수행할 수 있었습니다. 제프리 힌튼은 훨씬 발전한 반도체 기술을 적용해 새로운 방법을 연구했습니다. 그것은 인간이 아기일 때 누군가 정답을 알려주지 않아도 스스로 여러 번 시도하며 스스로 방법을 찾는 학습을 기계에 적용하는 것이었습니다.

제프리 힌튼은 기계에게 정답을 알려주고 기계가 제시한 값과 정답을 비교하며 수정하는 방법을 송두리채 바꿔 기계에게 정답을 알려주지 않고 기계가 데이터 간의 차이를 스스로 분류하고 판단하게 했습니다. 그러면 기계는 여러 히든 레이어Hidden Layer를 이용해 주어진 데이터의 특성을 스스로 판단하고 분류하며 미리 학습을 한 상태가 됩니다. 그 상태에서 네트워크를 연결해 데이터들을 총합하면 주어진 데이터를 기계가 받아 스스로 학습하고 결과값을 도출하게 됩니다.

제프리 힌튼은 2006년 이 매커니즘을 딥러닝Deep Learning이라고 명칭하며 새로운 인공지능 패러다임을 제시했습니다. 딥러닝Deep Learning은 각 히든 레이어Hidden Layer마다 데이터를 분석해 정보를 보유한 뒤 이를 연결하는 방식이었기 때문에 기울기 현상이 발생하지 않아 학습 효과가 높아지고 연결만 하면 되었기에 학습 효과도 비약적으로 빨라졌습니다. 이를 잘 보여준 사례가 2012년 이미지 인식 경진대회ILSVRC에서 딥러닝Deep Learning을 적용한 AlexNet이 이미지 인식률을 무려 84.7%로 끌어올린 예입니다. 딥러닝Deep Learning을 적용하지 않으면 이미지 인식률이 74.2% 정도로 75%를 넘지 못한 반면 딥러닝Deep Learning으로 학습한 인공지능은 적중률을 80% 이상으로 단숨에 끌어올린 것입니다.

- 딥러닝Deep Learning의 토대가 되는 기술의 발전

허나 딥러닝Deep Learning을 하려면 우선 데이터가 방대해야 하고 병렬 연산을 동시에 처리해야 하는 반도체 소자가 있어야 했습니다. 두 재료는 모두 실현에 비용이 매우 많이 들어 독자 개발은 불가능할 지경인 수준이었습니다. 하지만 다행히도 1995년 이후 급속도로 확장된 디지털 세계는 두 재료를 마련했습니다. 방대한 데이터는 인터넷이 전세계를 연결해 만든 거대한 정보의 바다에 있어 그 무한한 데이터를 공급받을 수 있었습니다.

그리고 병렬 연산을 하는 반도체 소자는 마침 발전한 GPU라는 소자가 있었습니다. 1993년 젠슨 황이 설립한 NVIDIA를 중심으로 GPU 기술이 눈부시게 발전했습니다. 들어오는 데이터를 순서대로 처리하는 CPU와 달리 모니터에 이미지를 렌더링하기만 하면 되는 GPU는 딱 렌더링할 연산만 할 수 있는 반도체를 여러 개 넣어 동시에 연산을 하고 결과값을 출력했기에 딥러닝에 아주 적합한 구조였습니다. 2006년 등장한 딥러닝Deep Learning은 운좋게도 세상을 바꾸던 인터넷과 GPU 덕에 날개를 달아 훨훨 날 준비를 했습니다.

'기술공학 > 세상을 바꾼 IT' 카테고리의 다른 글

| [세상을 바꾼 IT: 미래] Transformer, 창조의 힘을 얻은 인공지능 (46) | 2024.07.04 |

|---|---|

| [세상을 바꾼 IT: 미래] AlphaGo, 인간을 압도한 인공지능 (72) | 2024.07.03 |

| [세상을 바꾼 IT: 미래] 인공지능과 확장현실, 어쩌면 지금 일어나는 현실 (46) | 2024.07.01 |

| [세상을 바꾼 IT: 일상] Influencer와 網紅, 모바일 시대의 새 유명인 (79) | 2024.06.28 |

| [세상을 바꾼 IT: 일상] TikTok, 짧음의 미학 (51) | 2024.06.27 |

댓글