- 인공지능의 학습 정도를 파악하기 위해 탄생한 오토인코더Autoencoder

인류는 1950년대 컴퓨터가 막 태동할 때부터 컴퓨터가 스스로 생각하고 결과를 출력하게 하는 인공지능을 연구해왔습니다. 그리고 연구자들은 인공지능이 제대로 학습했는지 확인하기 위해 학습한 데이터를 그대로 다시 출력하게 해 학습이 잘 되었는지 확인하기 위해 모델을 만들었습니다. 그 모델은 오토인코더Autoencoder로 1990년대부터 인공지능 전문가들이 꾸준히 연구해온 모델입니다.

오토인코더Autoencoder는 퍼셉트론 모델을 두가지로 만든 구조로 입력받은 데이터를 학습하는 인코더Encoder와 학습한 데이터를 최대한 오차없이 복원하며 출력하는 디코더Decoder 두 구조를 연결한 구조입니다. 그래서 인코더Encoder에 데이터를 입력한 뒤 디코더Decoder로 인공지능이 학습한 데이터를 출력해 인공지능이 주어진 데이터를 얼마나 잘 학습했는지 확인했습니다. 오토인코더Autoencoder는 인공지능 연구자들이 인공지능이 데이터를 얼마나 잘 학습했는지 확인하는 용도로 개발되었지만 몇몇 인공지능 연구자들은 오토인코더Autoencoder를 응용하면 인공지능이 새로운 데이터를 스스로 생산할 수 있겠다고 생각했습니다.

- 학습결과 출력에서 새로운 창조로

인공지능 전문가인 디데릭 킹마는 인공지능이 학습한 데이터를 최대한 오차없이 출력하며 인공지능의 학습 정도를 파악하는데 사용되는 오토인코더Autoencoder를 좀 더 효율적으로 개량할 아이디어를 생각했습니다. 기존에는 인코더Encoder에서 학습받은 데이터를 디코더Decoder에서 하나하나 다 따져가며 똑같이 복원해야 했는데 그는 이 방법 대신 학습받은 데이터의 특징을 분석하는 과정을 추가해 일일이 복원하지 말고 그 특징을 살려 복원하는 방법을 고안했습니다. 그래서 그는 오토인코더Autoencoder에 인코더Encoder에서 입력받은 데이터의 특징을 분석하는 과정을 추가했습니다.

그는 이를 변분 오토인코더Variational autoencoder라고 명명했습니다. 변분 오토인코더Variational autoencoder는 인코더Encoder에서 주어진 데이터의 특징, 즉 분포를 여러 번 추출한 뒤 겹치는 분포들을 합쳐 샘플로 만듭니다. 즉 강아지 사진을 받았다면 강아지 사진을 여러 방법으로 분석해 분포를 추출한 뒤 네 다리가 달려있고 혀를 내민다는 등 공통된 분포를 모아 이들을 샘플로 저장합니다. 그 뒤 디코더Decoder에서 샘플에 따라 새로운 데이터를 생성합니다. 즉, 인공지능이 주어진 데이터를 파악하고 그 데이터를 기반으로 새로운 데이터를 생성하는 것입니다. 변분 오토인코더VAE는 최초로 인공지능이 직접 새로운 데이터를 생산하는 모델이었습니다.

- 서로 경쟁하며 발전하는 생성형 적대 신경망GAN

2013년 12월 디데릭 킹마는 변분 오토인코더VAE를 발표하며 스스로 데이터를 생성할 수 있는 인공지능을 제시했습니다. 이는 인공지능 학계에 큰 관심을 받았고 연구자들은 인공지능이 좀 더 방대한 정보를 정밀하게 창조할 수 있는 능력을 획득하는 방법을 연구했습니다. 2014년 이안 굿펠로우는 인공지능이 더 양질의 창조를 할 수 있는 모델을 제시했습니다. 그 모델은 창조하는 인공지능과 창조물을 검수하는 두 인공지능이 경쟁하는 생성형 적대 신경망Generative adversarial network입니다. 예를 들어 위조지폐를 생산하는 도둑과 위조화폐를 판별하는 경찰이 있다면 도둑은 경찰을 속이기 위해 더 정교한 위조화폐를 생산하고 경찰은 작은 차이도 감지하도록 더 정밀한 검사를 하게 됩니다. 그렇게 둘이 경쟁하다보면 위조화폐가 진짜 화폐와 구분할 수 없을 정도로 질이 상승합니다. 이 개념을 인공지능에 적용해 창조하는 인공지능과 검수하는 인공지능이 서로 경쟁하게 하는 것이 생성형 적대 신경망GAN입니다.

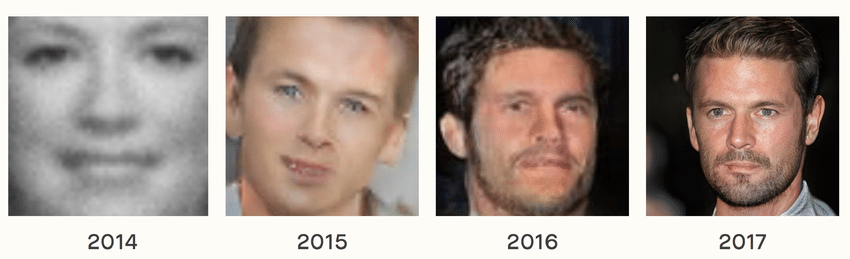

생성형 적대 신경망GAN는 입력값을 받아 새로운 데이터를 창조하는 생성자Generator과 생성자Generator가 창조한 데이터와 실제 데이터 두 데이터를 비교하는 판별자Discriminator 간의 경쟁으로 구성됩니다. 생성자Generator가 가짜 데이터를 생성하면 판별자Discriminator가 가짜 데이터와 진짜 데이터 둘을 비교해 어떤 데이터가 가짜이고 진짜인지 판별해 두 인공지능의 경쟁을 부추깁니다. 두 인공지능을 경쟁시킨 결과 실제로 생성자Generator는 더 실제같은 데이터를 생성하고 판별자Discriminator는 더 비슷한 두 데이터를 잘 비교하며 생성자Generator에게 더더욱 정교한 가짜 데이터를 생성하게 자극했습니다.

2014년 이안 굿펠로우는 생성형 적대 신경망GAN 이론을 창립하고 GANs라는 생성형 적대 신경망GAN 모델을 만들어 실험하고 논문으로 제출해 전세계에 알렸습니다. 생성형 적대 신경망GAN은 인공지능이 인류가 원하는 데이터를 추출하게 유도하는 가장 좋은 모델 중 하나로 인정받으며 생성형 적대 신경망GAN을 이용한 인공지능 연구가 진행되었습니다. 이로써 인공지능은 스스로 창조하는 힘을 얻었습니다.

- Attention is All You Need, Transformer의 탄생

변분 오토인코더VAE와 생성형 적대 신경망GAN 모델이 등장하며 인공지능은 스스로 새로운 데이터를 창조하는 힘을 얻었습니다. 하지만 두 모델은 새로운 데이터를 창조하는데 너무 많은 시간이 걸린다는 큰 단점을 가지고 있었습니다. 이는 주어진 데이터를 모두 탐색했기 때문에 벌어지는 일이었습니다. 그런 상황에서 2017년 Google Brain은 상당히 당돌한 아이디어를 제시했습니다. 그것은 인간이 글을 읽을 때 전문을 읽는 것이 아닌 특정 단어들에 집중해 그 단어 간의 관계를 파악하며 문맥을 이해하듯이 인공지능도 주어진 데이터에서 특정 분포들에 집중해야한다는 아이디어였습니다. Google Brain은 이를 Attention is All You Need라는 제목으로 논문에 제시했습니다.

Google Brain은 Attention is All You Need 논문에 제시한 새로운 모델을 Transformer로 이름을 지었습니다. Transformer는 인코더Encoder과 디코더Decoder 구조 두 구조로 구성되어있으며 추가로 어텐션 연산과 완전 연결 레이어가 있어 주어진 데이터 중 중요한 분포를 파악하고 그 분포 간의 관계를 계산하는 기능을 추가했습니다. 그래서 Transformer는 데이터가 주어지면 그 데이터 안에 중요한 분포들만 고른 뒤 그 분포들 간의 복잡한 관계를 파악해 학습하고 그 관계도로 만든 샘플을 통해 새로운 데이터를 창조하는 능력을 보유했습니다.

Transformer의 진가는 다른 모델보다 더 빠른 시간 안에 더 적은 자원소모로 더 양질의 데이터를 생성할 수 있다는 것이었습니다. 그래서 Transformer를 적용하면 다른 인공지능으로 출력한 데이터보다 더더욱 양질의 데이터를 빠르게 생성할 수 있어 인공지능 학계에서 Transformer는 만능키 취급을 받았습니다. 그리고 Transformer는 효율이 좋은 만큼 더 방대한 데이터를 한번에 학습할 수 있어 인공지능의 역량을 더더욱 키울 수 있는 토대를 마련했습니다.

- 언어모델LM의 구원자

Google Brain이 발표한 Transformer는 특히 언어모델Language Model을 비약적으로 발전시켰습니다. 언어모델LM은 인간이 인공지능에게 말을 하면 인공지능이 인간의 언어를 파악하고 인간이 알아들을 수 있는 언어로 답변을 출력하는 모델입니다. 이를 위해서는 인간이 한 말의 문맥과 의도를 파악하고 그에 가장 적절한 답변을 출력해야 했습니다. 하지만 인간은 애둘려 표현하거나 과정을 생략하며 말을 했기 때문에 인공지능이 인간이 한 말의 문맥과 의도를 파악하기란 매우 어려웠습니다. 이 어려움을 특정 단어를 추출하고 단어 간 관계를 파악하는 Transformer 모델로 쉽게 해결할 수 있었습니다.

덕분에 구글 번역기 등 인간의 언어를 파악하고 결과값을 출력하는 인공지능의 성능이 이전보다 비약적으로 발전했습니다. 그리고 인간의 언어를 파악하는 자연어처리National language processing 기술이 발전하며 더 긴 문장을 파악할 수 있게 되며 인공지능과 인간 관의 상호작용 문턱은 빠르게 낮아졌습니다. 2017년 인간과 인공지능 간의 마지막 장벽인 언어 문제가 빠르게 해결되며 인공지능은 인류의 삶에 스며들 준비가 되었습니다.

- Transformer에서 멈춘 Google과 새로 등장한 OpenAI

허나 2017년 Transformer라는 마법을 만들어 낸 Google은 정작 Transformer의 위력을 잘 알지 못했습니다. Google은 Transformer를 그저 인공지능 발전에 기여하는 많고 많은 기술 중 하나로만 치부하며 큰 관심과 투자를 하지 않았습니다. Google은 Google이 주도권을 잡는 폐쇠형 인공지능 개발에 열중했으며 막대한 개발 비용이 드는 Transformer 대신 더 가격이 저렴하며 성능이 좋은 인공지능 모델을 연구했습니다. 그리고 그 사이 Google에 대항하자는 뜻을 모은 일론 머스크와 샘 올트먼, 그렉 브록만이 힘을 합쳐 2015년 창립한 OpenAI가 Transformer을 현실화하려는 준비를 마쳤습니다.

'기술공학 > 세상을 바꾼 IT' 카테고리의 다른 글

| [세상을 바꾼 IT: 미래] Second Life, 가상현실의 청사진 (32) | 2024.07.08 |

|---|---|

| [세상을 바꾼 IT: 미래] chatGPT, 생성형 인공지능의 시대 (52) | 2024.07.05 |

| [세상을 바꾼 IT: 미래] AlphaGo, 인간을 압도한 인공지능 (72) | 2024.07.03 |

| [세상을 바꾼 IT: 미래] 딥러닝, 오랜 방황 끝에 찾은 길 (46) | 2024.07.02 |

| [세상을 바꾼 IT: 미래] 인공지능과 확장현실, 어쩌면 지금 일어나는 현실 (46) | 2024.07.01 |

댓글